「動画編集ソフトの使い方を覚える前に、AIに自動化ツールを作らせて作業が終わってしまった」

2026年の冬、X(旧Twitter)でそんな衝撃的なポストが話題になりました。 そこで使われていた技術が、「MCP」です。

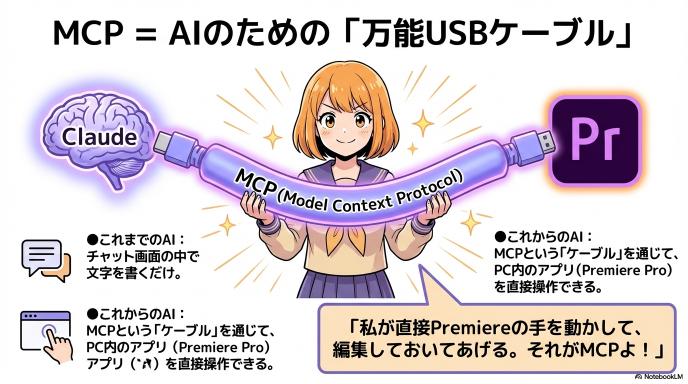

これまでAI(Claudeなど)は、チャット画面の中で文章を書くだけの存在でした。しかし、このMCPという仕組みを使うことで、AIがあなたのPCにある『Premiere Pro』を直接操作し、人間がやるはずだった面倒な作業を勝手に終わらせることが可能になったのです。

「えっ、もう人間は編集しなくていいの?」 「どうやって導入するの?」

この記事では、話題の「Premiere Pro MCP」とは一体何なのか、導入すると何が起きるのかをわかりやすく解説します。

音声のみはこちら↓

この記事でわかること:3分で掴む全体像

まずは、時間がない人のために「結局どうなるの?」「何がすごいの?」というポイントを3つにまとめました。

① Premiere MCPが「何をしてくれるか」

一言でいうと、「動画素材の中から“使いたいシーン”をAIが勝手に見つけて、タイムラインに並べてくれる」技術です。

例えば、1時間の対談動画があったとします。 「『AIの未来』について語っているシーンだけ抜き出して」 とClaudeにお願いすると、AIが動画の中身を解析し、その話題を話している部分だけを切り取って、Premiere Proのタイムラインに並べてくれます。人間はそれを調整するだけです。

② 動画編集のどこが速くなり、どこが難しくなるか

ここが重要なポイントです。魔法の杖ではありません。

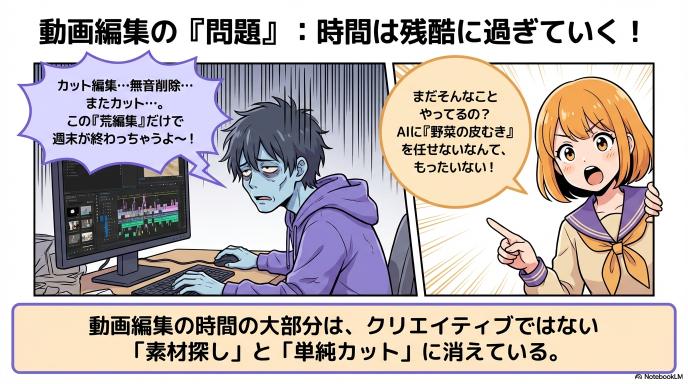

- 爆速になること: 「素材選び(OKカット探し)」と「荒編集(ざっくり並べる作業)」。これまで数時間かかっていた「動画を見返して、使える場所を探す時間」がほぼゼロになります。

- 難しくなること: 「最初の準備(セットアップ)」です。このツールを使うには、少しだけプログラミングに近い設定(コマンド入力など)が必要です。スマホアプリのように「インストールして終わり」ではありません。

③ 導入前に知っておくべき注意点(お金と安全)

- コスト: 高性能なAI(Claude 3.5 Sonnetなど)を使うため、動画を解析するたびに「API利用料」がかかります。長時間の動画を何本も解析すると、お財布に優しくない場合があります。

- プライバシー: AIに動画の中身を見せる=動画データをクラウド(外部サーバー)に送るということです。まだ世に出してはいけない極秘映像などを扱う場合は注意が必要です。

そもそも「Premiere MCP」って何?

「AIがPremiereを操作する」といっても、見えない手が出てきてマウスを動かすわけではありません。裏側で何が起きているのか、仕組みをサクッと解説します。

MCP=AIがあらゆるアプリを操るための“共通コントローラー”

「MCP(Model Context Protocol)」とは、AIにとっての「万能USBケーブル」のようなものです。

これまでのAIは、チャット画面の中に閉じ込められていました。 しかし、このMCPという「ケーブル」をつなぐことで、AIはGoogleドライブの中を見たり、パソコン内のファイルを操作したり、そして今回のようにAdobe Premiere Proというソフトを直接操作したりできるようになります。

「AI」と「Premiere」をつなぐための共通ルール、それがMCPです。

Premiere Proとどう繋がる?(裏口のカギを開ける)

では、どうやって接続しているのでしょうか? これには「プラグイン(拡張機能)」を使います。

- PC側(サーバー): Premiere Proを操作するための命令セット(「カットしろ」「配置しろ」などのプログラム)を準備します。

- Premiere側(プラグイン): Premiereの中に、AIからの命令を受け取るための「受信機(パネル)」をインストールします。

この2つが連携することで、あなたがClaude(チャット画面)に「あのシーンを探して!」と指示すると、その命令がMCPを通じてPremiere内の受信機に届き、あなたの代わりにプログラムが動画を編集してくれるというわけです。

「AIが作品を作る」のではなく「下準備を終わらせる」発想

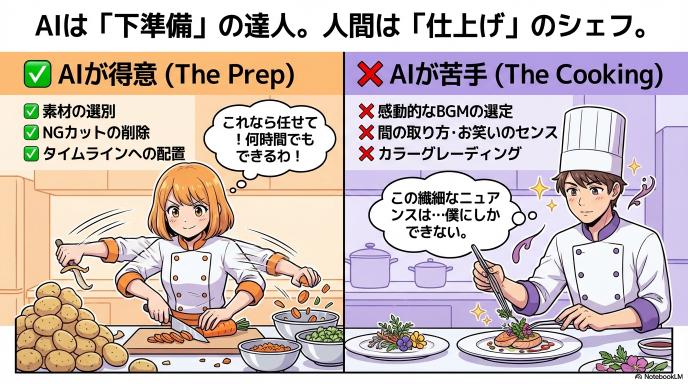

勘違いしやすいのが、「AIがカッコいいYouTuberっぽい動画を完パケてくれる」わけではない、という点です。

現在公開されている「Premiere MCP(toonyai版など)」が得意なのは、「素材の選別と配置」です。

- ❌ できないこと: 「感動的な音楽に合わせて、いい感じのエフェクトをかけ、面白いテロップを入れる」

- ✅ できること: 「3時間の撮影データから、社長が『売上』について話している15秒だけを探し出し、タイムラインの先頭に置く」

つまり、「料理(仕上げ)」は人間がやるけど、「野菜の皮むきやカット(下準備)」は全部AIがやっておいてくれる、最強のアシスタントだと考えてください。

Premiere MCPでできること(動画編集者目線)

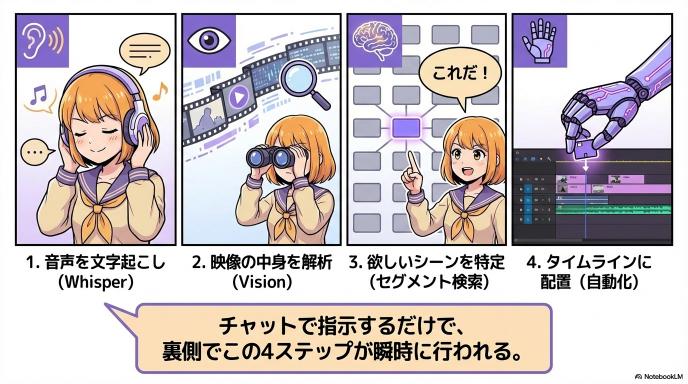

「AIと連携する」と言っても、具体的にどんなボタンが増えるわけではありません。 チャット画面(Claude)にお願いすることで、裏側で以下の4つのステップが自動的に行われます。これが「魔法」の正体です。

1. 音声を文字起こしして“探せる素材”にする(Whisper)

まず、AIは動画の「耳」になります。 OpenAIの「Whisper(ウィスパー)」などの技術を使って、動画内の会話をすべて文字に書き起こします。

- これまで: 「あの発言、どこだっけ?」とタイムラインを何度も再生して探していた。

- これから: 動画が「検索できるテキスト」に変わります。「えー」「あー」といった不要な言葉の削除も、文字データなら一瞬です。しかも、「05分12秒〜05分15秒」といった秒数まで正確に記録されます。

2. 映像の内容を把握して“画で探す”(Vision解析)

次に、AIは動画の「目」になります。 Claudeの画像認識機能(Vision)を使って、動画のフレーム(コマ)をパラパラ漫画のように見て、「何が映っているか」をタグ付けしていきます。

- できること: 「ホワイトボードが映っているシーン」「人物が笑った瞬間」「商品がアップになった画面」などをAIが理解します。

- メリット: 音声がないBロール(インサート映像)や、リアクション映像も言葉で探せるようになります。

3. 「使える瞬間」だけ抜き出す(セグメント検索)

ここからがMCPの真骨頂です。 音声(耳)と映像(目)の情報を組み合わせて、あなたが欲しいシーンの「開始点(イン点)」と「終了点(アウト点)」をAIが特定します。

例えば、「この動画から、新製品のデメリットについて話している部分を全部抜き出して」と指示すると、AIは文字起こしデータから該当する話題を探し、「03:10〜03:45」と「12:00〜12:20」が該当する、と判断します。

4. 見つけた区間をタイムラインに自動配置(Insert/Overwrite)

最後に、特定した区間をPremiere Proのタイムラインに物理的に並べます。

これまでは人間がマウスで「ドラッグ&ドロップ」していた作業を、プログラムが代わりに実行します。 チャットで指示を出して数秒後、ふとPremiereの画面を見ると、すでにクリップが綺麗に並んでいる。これが「Premiere MCP」がもたらす体験です。

実際の制作フローはどう変わる?

では、このツールを導入すると、毎日の編集作業は具体的にどう変わるのでしょうか?

素材取り込み〜荒編集が「検索→配置」に置き換わる

動画編集で一番時間がかかり、かつ退屈なのが「荒編集」です。 数時間ある撮影データから、NGシーンを切り捨て、OKシーンだけを並べる作業です。

- Before(これまで): 素材を端から端まで再生し、ショートカットキーを連打してカット、不要部分を削除、隙間を詰める……この繰り返しで数時間が溶けていました。

- After(これから): 素材を読み込ませたら、AIに「検索」をかけます。「一番盛り上がっている会話」「結論部分」をAIに見つけさせ、「配置」ボタン(に相当する指示)を押すだけ。 料理で言えば、「野菜を洗って皮を剥き、一口サイズに切る」ところまでを全自動化するイメージです。

カット点を“自分で探す時間”が減る(インタビュー/対談に強い)

特に威力を発揮するのが、YouTubeの対談動画、企業のインタビュー、ポッドキャストなど「喋り」がメインの動画です。

「1時間の対談から、10分のダイジェスト動画を作りたい」 そんな時、これまでは1時間すべてを聞き直す必要がありました。しかしMCPを使えば、「この対談の要点を5つピックアップして、それぞれ動画として並べて」と頼むだけで、ダイジェスト版の骨組みが完成します。 人間は、AIが並べたものを見て「これは採用、これは不採用」とジャッジする監督(ディレクター)になるのです。

テロップ・BGM・色調整など、AIが触りにくい領域は残る

とはいえ、AIも万能ではありません。 現時点のPremiere MCPが得意なのは「カット編集(素材の配置)」までです。

- まだAIが苦手なこと:

- 「この場面に合った感動的なBGMを入れる」

- 「お笑い番組のような、絶妙なタイミングのテロップを入れる」

- 「映画のような色味(カラーグレーディング)に調整する」

これらは文脈やセンスが必要なため、まだ人間の手が必要です。 逆に言えば、面倒なカット作業をAIに任せた分、人間はこうした「クリエイティブな演出」に全時間を注げるようになるとも言えます。

【YouTuber必見】明日から使える!具体的な活用シーン5選

「すごい技術なのはわかったけど、結局どう使えば楽になるの?」 そう思うクリエイターのために、明日から使える具体的なテクニックを5つ紹介します。これを取り入れるだけで、編集時間が半分以下になるかもしれません。

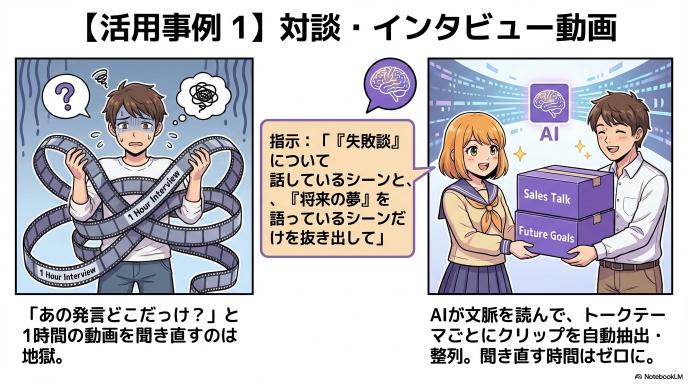

トーク動画:キーワード別に“使える発言”を自動で並べる

コラボ動画やラジオ動画など、1時間以上カメラを回しっぱなしにする撮影では、編集の8割が「聞き直し」に使われます。 MCPを使えば、この苦行から解放されます。

例えば、**「この動画の中で、『失敗談』について話している部分と、『これからの目標』について話している部分を全部抜き出して」**とAIに指示を出します。 するとAIが会話の流れを読み取り、該当するトークテーマごとにクリップを整理して並べてくれます。あなたはそれを聞いて、面白くない部分を削除するだけ。「えーっと、あの話どこだっけ?」とタイムラインを行ったり来たりする必要はもうありません。

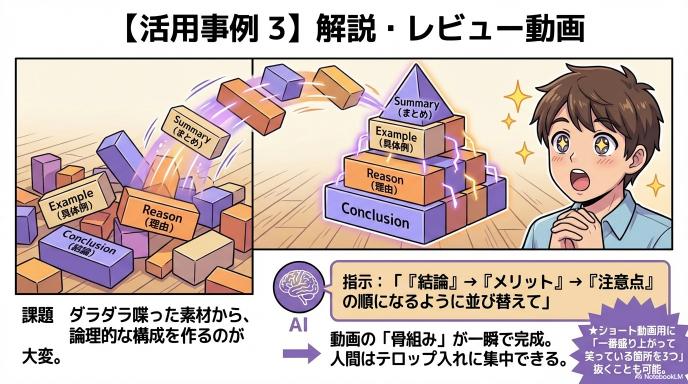

解説動画:章立ての材料(要点区間)を先に回収する

商品解説や教育系の動画では、「構成」が命です。 ダラダラと喋ってしまった素材から、プレゼンのように綺麗な構成を作るのは骨が折れます。

ここで役立つのが、「『結論』『理由』『具体例』『まとめ』の順番になるように、発言を並び替えて配置して」という指示です。 AIが論理構成を理解し、あなたのトークから必要なパーツを抜き出して並び替えてくれます。タイムライン上に動画の「骨組み」が一瞬で出来上がるので、あとはテロップを入れる作業に集中できます。

Vlog:場所/シーン(屋外・店内・料理など)で見どころ抽出

旅行Vlogなど、無駄に撮りすぎた素材(3時間分など)から「画」を探すのは大変です。 特に、喋っていない風景だけのシーン(Bロール)は、音声検索では見つけられません。

そこで活躍するのが「映像解析(Vision)」です。 「『料理を食べているシーン』と『海が映っているシーン』だけを探して並べて」 こう指示すれば、AIが映像の中身を見て判断してくれます。「移動中の地面を撮っていただけの無駄なシーン」を見る必要はもうありません。

レビュー:結論・比較・注意点の発言だけ先に集める

ガジェットやコスメのレビュー動画で、視聴者が一番見たいのは「結論」です。

「『メリット』と言っている部分と、『デメリット(注意点)』と言っている部分を抽出して」 この指示ひとつで、動画の核心部分だけがタイムラインに揃います。あとは冒頭の挨拶と、インサート映像を足せば完成です。「結局どれがいいの?」という視聴者の疑問に答えるダイジェスト動画も、数分で作れてしまいます。

ショート:盛り上がり区間を拾って15〜30秒に圧縮する

長尺動画からTikTokやYouTubeショートを作りたい時にも役立ちます。

「この動画の中で、一番声が大きくなって笑っている箇所を3つピックアップして」 AIは音声の波形や文脈から、感情が高ぶった「バズりそうな瞬間」を判断できます。ショート動画の種(ネタ)が自動で見つかるので、切り抜き動画を量産したい人には最強のツールになるでしょう。

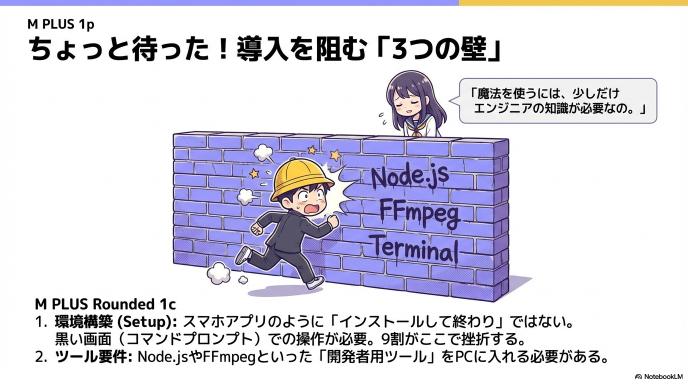

ちょっと待った!導入前に知っておくべき「3つの壁」

ここまで読むと「今すぐ使いたい!」と思うかもしれませんが、正直に言います。導入はかなり難しいです。 スマホアプリのように「ダウンロードして終わり」ではありません。以下の3つの壁を乗り越える必要があります。

必要なもの(FFmpeg / APIキー / Node.js など)

これらは、いわば「エンジニアの道具」です。

- Node.js(ノード・ジェーエス): このツールを動かすためのエンジン。

- FFmpeg(エフエフエムペグ): 動画をAIが読めるように変換するための「包丁」のようなソフト。

- APIキー: AI(Claude)を使うための「有料パスポート」。

これらを自分のパソコンにインストールし、黒い画面(コマンドプロンプト/ターミナル)に文字を打ち込んで設定する必要があります。ここで「何語?」となって挫折する人が9割です。

APIコストはどれくらい考える?(素材尺×解析回数)

このツールは、パソコンの中だけで完結するわけではありません。動画の中身をClaude(AIのサーバー)に送って見てもらうため、「従量課金」でお金がかかります。

最新の高性能AI(Claude 3.5 Sonnetなど)を使う場合、1時間の動画をフル解析すると、数百円〜千円単位でお金がかかる可能性があります(※画像の枚数や会話量によります)。 定額制(サブスク)ではないので、「便利だから!」と何十本も解析していると、月末にAIの利用料請求を見て青ざめることになるかもしれません。

PCスペックと処理時間(ローカル解析の現実)

AIに送る前に、パソコン内で「音声の文字起こし」などの下準備をする必要があります。これにはゲーミングPC並みのスペック(特にGPU/グラフィックボード)が推奨されます。

低スペックなノートPCだと、1時間の動画の解析に2時間以上かかることもあります。「自分で編集したほうが速かった……」とならないよう、ある程度のマシンパワーが必要です。

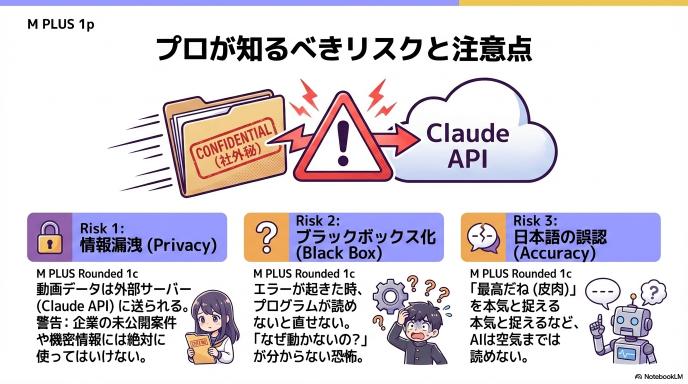

注意点とリスク:便利さの裏にある「落とし穴」

ここまで夢のような機能を紹介してきましたが、プロの編集者ほど気になるのが「リスク」の話でしょう。 Premiere MCPは強力なツールですが、仕事で使うにはいくつか超えなければならないハードルがあります。

素材が外部APIに送られる可能性(案件・未公開情報の扱い)

最大のリスクは「情報漏洩」です。 この仕組みは、あなたのPCにある動画データを、インターネットを通じてClaude(Anthropic社のサーバー)に送信し、そこで解析を行います。

例えば、あなたが趣味で撮影したVlogなら問題ないかもしれません。しかし、これが企業の案件動画や、まだ世に出ていない新製品のレビュー動画だったらどうでしょうか? 「機密情報を外部のサーバーにアップロードした」という事実だけで、契約違反になる可能性があります。便利な反面、扱うデータの重要度によっては、そもそも仕事では使えないケースも多いのが現実です。

誤認識は起きる(文字起こし/映像理解の限界)

AIは優秀ですが、完璧ではありません。 特に日本語は「橋」と「箸」のような同音異義語や、文脈によるニュアンスの違いが難しい言語です。

- よくあるミス:

- 皮肉で言った「最高だね」を、本当に褒めていると勘違いして採用してしまう。

- 日本独自の文化的な映像(例:お辞儀)の意味を正しく理解できない。

結局、AIが作ったものを人間がチェックする工程は必ず発生します。「100%全自動」を信じすぎると、痛い目を見ることになります。

ブラックボックス化する(壊れた時に直せない問題)

もう一つの問題は、「なぜ動いたか」がわからない怖さです。 自分で手作業で編集していれば、ミスがあっても「あ、ここで間違えたな」と気づけます。しかし、AIに全自動でやらせていると、エラーが起きた時に何が原因かさっぱりわかりません。

「急ぎの納品前なのに、なぜかAIが動かない!」 そんな時に、裏側のプログラムを理解していないと手も足も出なくなります。便利さと引き換えに、「トラブルが起きたら自分では直せない」というリスクを背負うことになります。

自動化しすぎると編集スキルは伸びにくい

AIに頼りきりになると、「動画のリズム感」が身につきにくくなります。 編集者は、何百時間も素材を見返し、コンマ数秒のカット調整を繰り返すことで、「人が心地よいと感じる間」を身体で覚えます。 最初からAIが選んだ「正解っぽいもの」だけを見ていると、この「肌感覚」が育たず、AIが作ったもの以上の作品を作れないクリエイターになってしまうかもしれません。

「Premiereを覚える前に自動化」問題をどう考える?

今回話題になった「初心者がいきなり自動化ツールを使うのはアリかナシか」という議論。 これからの動画編集者はどう向き合うべきでしょうか?

習熟を捨てて得るもの=構成力とスピード

結論から言えば、「編集者の役割が変わった」と捉えるべきです。

これまでの動画編集は、ショートカットキーを覚え、マウス操作を極める「職人芸」の世界でした。しかし、MCPを使えば、その修行期間をスキップできます。 浮いた時間はどこへ行くのか? それは「どんな動画を作るか」という企画や構成(ディレクション)に使われます。

操作を覚える時間を、面白い動画を作るための「脳みそを使う時間」に回せる。これは、クリエイターにとって間違いなく大きな武器になります。

習熟が必要な場面=トラブル対応・仕上げ品質

ただし、**「最後の一手間」**には必ず人間のスキルが必要です。 AIが作った荒編集は、あくまで「70点」の出来栄えです。そこから「100点」の作品に仕上げるには、結局のところ泥臭い手動編集が必要になります。

- テロップの表示タイミングを0.1秒ずらす

- 演者の顔色がよく見えるように色を調整する

- 複数のカメラの映像がズレているのを直す

こうした「こだわり」や「トラブル対応」は、まだAIにはできません。基礎を知らないと、AIが出してきた70点の動画をそのまま出すことしかできなくなります。

おすすめの折衷案(荒編集はAI、仕上げは手動)

最強なのは、「AIにざっくり作らせて、最後は自分の手で完璧に仕上げる」ハイブリッドなスタイルです。

「全部手動」は時間がかかりすぎますし、「全部AI任せ」ではクオリティに限界があります。 「単純作業(荒編集)はAI、クリエイティブ(演出)は人間」。 この使い分けができる人こそが、AI時代の動画編集で生き残っていく「賢い編集者」だと言えるでしょう。

向いている人/向いていない人

最後に、この技術を今すぐ導入すべきなのはどんな人か、整理しておきましょう。 「流行っているから」という理由だけで導入すると、設定の難しさに挫折するだけかもしれません。

向いている:長尺トーク・編集の8割が“探す作業”の人

YouTubeの対談動画、セミナー、イベントの記録映像、長時間のゲーム実況など、とにかく「素材が長くて、どこを使うか探すのが大変」なジャンルを扱っている人です。 編集時間のほとんどが「再生バーを動かして、無言部分をカットする作業」で消えているなら、このツールはあなたの救世主になります。

向いていない:MV/凝ったモーショングラフィックス中心の人

逆に、ミュージックビデオ(MV)や、こだわりのVlog、ショートフィルムを作っている人には向きません。 音楽のビートに合わせて1フレーム(0.03秒)単位でカットを変えたり、映像の色味で感情を表現したりといった「感性」が重要な編集は、まだAIには荷が重すぎます。苦労して導入しても、「自分でやったほうが早いし良いものができる」という結果になるでしょう。

導入判断のチェックリスト(3分で判断)

迷っているなら、以下のリストをチェックしてみてください。

□ 扱う動画素材の長さが、毎回30分以上ある

□ 動画のメインは「人の会話」である

□ 黒い画面(コマンドプロンプト)に文字を打ち込むことに抵抗がない

□ 月に数千円程度のAPI利用料(AIへの課金)なら必要経費だと思える

これらすべてにチェックが入るなら、あなたは今すぐにでも導入を検討すべき「選ばれし人」です。

まず試すならこの使い方(最短で効果が出る)

いきなり「全自動化」を目指すと失敗します。まずは小さな作業からAIに任せてみましょう。おすすめの3ステップです。

1本目:文字起こし→「使える発言」3つだけ自動配置

最初は欲張らず、「検索」の威力を試します。 AIに動画を読み込ませたら、「一番盛り上がっている発言を3つだけタイムラインに並べて」と頼んでみてください。 数秒後にPremiere上にクリップが現れる瞬間を見れば、「あ、これなら使える」と確信できるはずです。

2本目:章立て(導入/結論/補足)で区間回収

慣れてきたら、動画の「構成」を任せます。 「この動画を『導入(挨拶)』『本題』『まとめ』の3つのパートに分けて、それぞれタイムラインに配置して」と指示します。 これで荒編集(骨組み作り)が完了します。人間は、その間をつなぐ作業をするだけです。

3本目:テンプレ化して“1ボタン”に寄せる

毎回同じ指示をするのは面倒です。うまくいった指示文(プロンプト)をメモしておき、コピペで使えるようにします。 これが、冒頭で話題になった「やりたかった作業全部1ボタン」の状態です。ここまで来れば、あなたはもう立派な「AI編集ディレクター」です。

まとめ:編集は「操作」から「設計」へ

Premiere MCPが私たちに見せてくれたのは、「動画編集=パソコンの操作」という常識が崩れる瞬間です。

Premiere MCPは“荒編集の自動化装置”

勘違いしてはいけないのは、AIが「面白い動画」を作ってくれるわけではないということです。 AIがやってくれるのは、あくまで「面倒な下準備(素材探し・カット)」まで。料理で言えば「野菜の皮をむいて切る」ところまでです。 どう味付けして、どう盛り付けるか(演出・テロップ・BGM)は、まだ人間の仕事として残されています。

省ける時間を、企画・構成・演出に回せるかが勝負

このツールを使う最大のメリットは、「時間の節約」ではありません。「脳の節約」です。 単純作業で脳を疲れさせるのをやめ、浮いたエネルギーを「次はどんな企画をやろうか?」「サムネイルはどうしようか?」というクリエイティブな「設計」に回せるか。

これからは、どれだけ速くキーボードを叩けるかではなく、「AIにどんな指示を出して、浮いた時間で何を生み出すか」が、クリエイターの勝負の分かれ目になるでしょう。

コメント