TikTokやCapCutを運営するByteDance(バイトダンス)から、動画制作の世界をひっくり返すような新しいAI、「Seedance 2.0」が登場しました。

これまでの動画生成AIといえば、指示を出しても思うような絵が出ない「ガチャ」のような運任せな部分があったり、せっかく動画ができても「音」がなくて無音だったりと、実用にはあと一歩足りない印象がありましたよね。

しかし、今回現れたSeedance 2.0は違います。映像だけでなく「音」まで完璧に同期して作り出し、さらに監督のように細かく演出を指示できるというのです。

この記事では、現在テスト公開中で謎の多いSeedance 2.0について、何がそんなに革命的なのか、そして具体的にどんなことができるのかを、分かりやすく噛み砕いて解説します。

音声のみはこちら↓

そもそも「Seedance 2.0」って何?世界が震えた3つの理由

「映像」だけじゃない!「音」まで勝手に作ってくれる衝撃

Seedance 2.0を一言で表すなら、「映像と音を同時に生み出す、マルチな才能を持ったAI」です。

SoraやKlingといった他の有名な動画生成AIは、基本的に「映像を作る」ことに特化しています。そのため、出来上がった動画は無音で、BGMや効果音はあとから人間が編集ソフトで足す必要がありました。

ところがSeedance 2.0は、映像を生成する瞬間に、その映像に合ったBGMや、ドアが閉まる音、足音といったSFX(効果音)、さらにはキャラクターのセリフに合わせた口の動き(リップシンク)まで、すべてをセットで作り出します。「後付け」ではなく「最初から音が映像に馴染んでいる」状態で出力されるため、動画制作の手間が劇的に減ると期待されているのです。

どこで使えるの?「Jimeng」「Dreamina」の複雑な関係を整理

「Seedance 2.0」というのは、あくまでAIの頭脳(モデル)の名前です。私たちが実際に使うアプリやサービスの名前は少し違うので注意が必要です。

現在は主に、ByteDance社が提供する「Jimeng AI(即夢)」というプラットフォームや、クリエイティブツール群である「Dreamina(ドリーミナ)」の中で、このSeedance 2.0の機能がテスト提供されています。

つまり、将来的に皆さんが使うときは「Dreamina」などのアプリを通じて、裏側で動いているSeedance 2.0のパワーを体験することになるでしょう。現在は限定的なベータ版としての公開が中心ですが、CapCutなどの身近なアプリに統合される日も近いかもしれません。

他の動画AIと何が違う?(参照入力・複数カット・音の統合)

ライバルであるOpenAIの「Sora」やGoogleの「Veo」と比較して、Seedance 2.0が圧倒的に評価されているポイントは「コントロールのしやすさ」にあります。

これまでのAIは、「猫が走る動画」と文字で打っても、どんな猫が出るか、どんな走り方をするかはAI任せでした。しかしSeedance 2.0は、「この写真の猫を使って」「この動画のようなカメラワークで」「この音楽のテンポに合わせて」といったように、手持ちの素材(リファレンス)を渡して細かく指示が出せます。

これを「マルチモーダル参照」と呼びます。単にリアルな動画が出るだけでなく、「作り手の意図通りに動かせる」点が、プロのクリエイターたちを唸らせている最大の理由なのです。

これさえ知ればOK!Seedance 2.0の「5つの魔法」

では、具体的にどんな機能を使って動画を作れるのでしょうか。Seedance 2.0が持っている5つの主要な機能を見ていきましょう。

【T2V】文字だけで映像を作る:妄想を10秒で現実に

まずは基本の機能です。「夕暮れの海辺を走るスポーツカー」のように文章(プロンプト)を入力すると、AIがその情景を想像して映像化してくれます。 Seedance 2.0は文章の理解力が非常に高く、指定した動きや雰囲気を忠実に再現するのが得意です。まだ素材が何もないゼロの状態からアイデアを形にするのに向いています。

【I2V】1枚の絵が動き出す!イラストに命を吹き込む技術

手持ちの画像やイラストをアップロードして、それを動画として命を吹き込む機能です。 例えば、自分で描いたキャラクターのイラストをアップして「振り向いて」と指示すれば、そのキャラのデザインや絵柄を保ったまま、滑らかに振り向く動画が作れます。これまでのAIでよくあった「動いた瞬間に顔が別人になってしまう」という失敗が起きにくいのが大きな強みです。

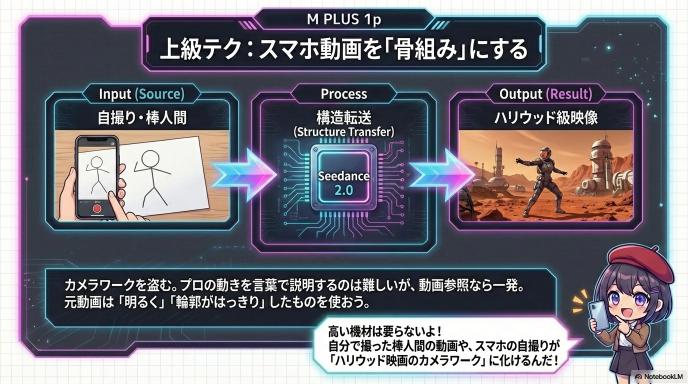

【V2V】スマホ動画がSF映画に?「動き」だけを借りる裏技

すでにある動画を「手本」として読み込ませ、別の動画に変換する機能です。これが非常に強力で、クリエイティブの幅を一気に広げます。

例えば、自分がスマホで撮影した「公園を歩く動画」を読み込ませて、「アニメ風のサイバーパンクな世界にして」と指示を出したとします。すると、歩くスピードやカメラの揺れといった「動き」はそのままに、画面の世界観だけがSFアニメに書き換わった動画が出来上がります。プロの映画のようなカメラワークの動画を手本にすれば、その演出テクニックを自分の動画にコピーできるわけです。

【音声同期】リップシンクも完璧。もう「無音動画」には戻れない

これこそがSeedance 2.0の真骨頂です。映像生成と同時に音まで作ってしまいます。

もし映像の中でガラスが割れれば「ガシャーン」という音が、犬が吠えればそのタイミングで鳴き声が、自動的に生成されます。さらに、キャラクターの画像と「喋らせたい音声データ」を渡せば、その音声に合わせて口を動かす「リップシンク動画」も簡単に作れます。これまで動画編集ソフトで波形を見ながら調整していた作業が、AIにお任せで完了してしまいます。

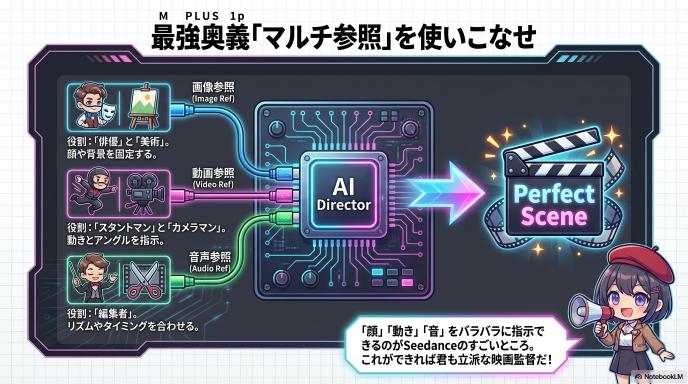

【複数参照】AIの「ガチャ」は終わり。指示通りに動かす最強機能

これは少し上級者向けの機能ですが、Seedance 2.0の最もすごい点と言えるかもしれません。なんと、参考にする素材(リファレンス)を最大12個まで同時にAIに見せることができるのです。

「キャラクターはこの画像(画像参照)」 「動きはこの動画の通りに(動画参照)」 「雰囲気はこの音楽に合わせて(音声参照)」

これらを全部まとめてAIに渡すことで、「キャラの顔は固定しつつ、動きはプロの真似をして、音にもバッチリ合わせる」という、まさに映画監督のような細かい指示が可能になります。「作ってみないと分からない」というAI動画のギャンブル要素を極限まで減らし、狙った通りの作品を作れる機能です。

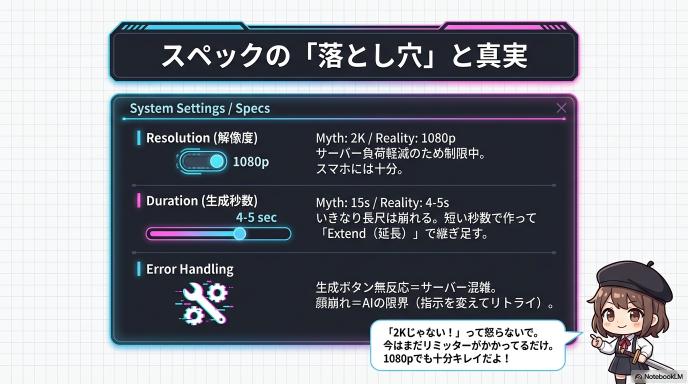

騙されないで!スペックの「落とし穴」と正しい見方

「ニュースでは2K画質って書いてあったのに、自分の画面では1080pしか選べない…?」 そんな風に戸惑わないよう、現在のSeedance 2.0の仕様について、情報のズレを整理しておきましょう。

「2K画質」の嘘と本当:あなたの画面で1080pな理由

まず画質についてです。多くのテック系ニュースサイトでは「Seedance 2.0はネイティブ2K対応!」と華々しく報じられています。しかし、実際に「Dreamina」などのツールを開いてみると、設定画面には「720p」や「1080p」しか表示されないことがあります。

これは、「AIモデル本来の実力」と「サービスとして提供される制限」の違いです。 Seedance 2.0というAIの脳みそ自体は、確かに2Kの高画質映像を作る能力を持っています。ですが、世界中の何万人ものユーザーが同時に2K動画を作ろうとすると、サーバーがパンクしてしまいますよね。そのため、現在公開されているベータ版や無料プランでは、あえて画質をフルHD(1080p)程度に抑えて提供されていることが多いのです。

今後、有料のProプランや正式版が登場すれば、本来の「2K」が開放される可能性が高いでしょう。現状でも1080pあればスマホで見るには十分綺麗ですので、「今はまだリミッターがかかっているんだな」くらいに捉えておいてください。

「15秒」は作れない?プロが「5秒」で刻む本当のワケ

次に動画の長さ(秒数)です。ここも情報が錯綜しやすいポイントです。「最大15秒」という表記もあれば、ツールの画面では「5秒」がデフォルトになっていることもあります。

基本的な考え方として、このAIは「4〜5秒」を1つの単位として動画を作るのが得意だと覚えておきましょう。 いきなり「15秒の動画」を一発で生成しようとすると、後半になるにつれて映像が崩れたり、動きが不自然になったりしがちです。そのため、ツール側ではあえて「5秒」や「12秒」といった短めの選択肢を用意して、失敗を防ごうとしています。

まずは短い秒数で生成してみて、うまくいったら「Extend(延長)」機能を使って継ぎ足していく。これが、高品質な長尺動画を作るための近道です。

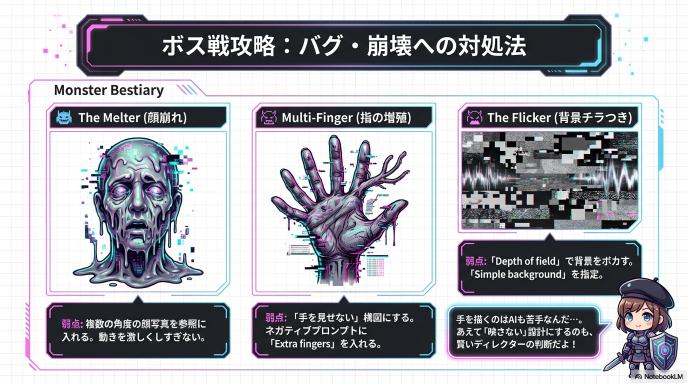

これってバグ?「顔が崩れる」ときの正しい対処法

使っていると「あれ? うまくいかない」という場面に出くわすと思います。それがAIの限界(仕様)なのか、アプリの不具合なのかを見極めるコツがあります。

もし「生成ボタンを押しても反応しない」「エラー表示が出る」といった場合は、プラットフォーム側の不具合や混雑である可能性が高いです。時間を置いて再トライしましょう。

一方で、「キャラクターの顔が途中で別人になる」「指の本数がおかしい」「動きが怖い」といった現象は、AIの仕様(能力の限界)です。これは不具合ではないので、指示する文章(プロンプト)を変えたり、参考にする画像(リファレンス)を別のものに差し替えたりして、もう一度生成し直す必要があります。いわゆる「ガチャを引き直す」作業ですね。

【炎上回避】使う前に絶対チェック!著作権とバレないルールの話

最後に、作った動画を公開する前のチェックポイントです。 現在テスト公開されているバージョンの多くは、生成された動画の隅っこに「Jimeng」や「Dreamina」といったロゴマーク(ウォーターマーク)が入ります。これを無理やり消して公開したり、勝手に企業の広告に使ったりするのは、利用規約で禁止されているケースが一般的です。

特に「商用利用(ビジネスで使うこと)」については、ベータ期間中はNGだったり、有料プランへの加入が必須だったりとルールが厳格です。トラブルを避けるためにも、使う前には必ず利用規約(Terms of Service)に目を通すクセをつけておきましょう。「みんながやってるから大丈夫」は危険です。

初心者脱出!「失敗しない動画」を作る黄金の5ステップ

高機能なSeedance 2.0ですが、適当にいじっているだけでは「なんか凄いけど使い道がない動画」が量産されて終わりがちです。 プロのような作品を作るためには、料理と同じで「段取り」が重要です。ここでは失敗しないための5つのステップを紹介します。

Step 1:いきなり作るな!「誰に見せるか」で勝負は決まる

最初に「何を作るか」を決めましょう。これがないと、画面サイズすら選べません。

例えば、TikTokやインスタのリールに投稿したいなら、画面は「縦長(9:16)」で、最初の1秒でインパクトがある動きが必要です。一方で、YouTubeの解説動画やマンガ動画を作りたいなら、「横長(16:9)」で、キャラクターの顔が変わらないこと(一貫性)が何より重要になります。 「誰に、どこで見せるのか」を決めるだけで、選ぶべき機能が自然と決まってきます。

tep 2:AIは料理人。最高級の「素材(リファレンス)」を集めろ

ここがSeedance 2.0を使う上で一番大切な工程です。いきなり生成ボタンを押すのではなく、まずは「材料」を集めます。

主人公にしたいキャラクターの画像、舞台となる背景のイラスト、「こんな動きをしてほしい」という参考動画(自分でスマホで撮った簡単なものでOKです)、そして使いたいBGMやナレーション音声。これらをフォルダにまとめておきましょう。 Seedance 2.0は、0から1を生み出すのも上手ですが、渡された材料を組み合わせて「100」にするのがもっと得意なAIです。良い材料(参照ファイル)が多ければ多いほど、完成度は跳ね上がります。

Step 3:指示出しの極意。「文字」より「画像」を見せつけた方が早い

素材が集まったら、いよいよ入力です。ここでポイントなのが、プロンプト(文字)だけで頑張らないこと。 「青い服を着た金髪の少年が走る」と文字だけで伝えても、AIは勝手な想像で動画を作ってしまいます。これが「ガチャ」になってしまう原因です。

これを防ぐために、ステップ2で集めた素材を「Reference(参照)」という枠にアップロードします。「この画像のキャラで」「この動画の動きで」と視覚的に指示を出すことで、AIの想像の余地を狭め、イメージ通りの動画が出る確率をグッと上げることができます。これがSeedance 2.0を使いこなす最大のコツです。

Step 4:欲張るな危険。「短いカット」の積み重ねが神動画を生む

生成ボタンを押すときは、欲張らずに「4〜5秒」で設定しましょう。 最初から長い動画を作ろうとすると失敗したときのダメージも大きいですし、AIもボロが出やすくなります。

まずは短いカットを作ってみて、動きや顔が崩れていないか確認します。もし良い出来なら、その動画の続きを作る「Extend(拡張)」機能を使って伸ばしていくか、別のシーン(カット)を作って後で繋げればいいのです。映画やアニメも、実は数秒のカットの積み重ねでできていますよね。それと同じ作り方が一番確実です。

Step 5:最後の仕上げは人間で。AIにできない「味付け」とは?

納得のいく動画ができたらダウンロードしますが、これで完成ではありません。 Seedance 2.0は音も生成してくれますが、最後の仕上げは人間がやったほうがクオリティが一段上がります。

動画編集アプリ(CapCutなど)に取り込んで、セリフに字幕(テロップ)を入れたり、フィルターで全体の色味を整えたりしましょう。また、AIが作ったBGMの音量が大きすぎたり、タイミングが少しズレていたりすることもあるので、ここで微調整します。 この「ひと手間」を加えるだけで、AIで作った動画特有の違和感が消え、プロが作ったような作品に仕上がります。

【実践編】明日から使える「プロ級テクニック」大公開

Seedance 2.0には、大きく分けて3つの入り口(モード)があります。それぞれのモードには「得意なこと」と「コツ」があるので、目的別に見極めていきましょう。

文字指示(プロンプト)の正解:AIに伝わる「4つの呪文」

一番シンプルな「文字だけで動画を作る」モードです。 ここでやりがちな失敗が、最初から小説のように長文を書いてしまうこと。情報量が多すぎるとAIが混乱し、何を描けばいいのか分からなくなってしまいます。

成功のコツは、「誰が」「どうした」を短く言い切ることです。 例えば、「美しい森の中で、一人の少女が振り返り、その髪が風になびいて……」と書くよりも、「森の中の少女、振り返る、風になびく髪」と単語で区切ったり、短い英語で指示を出したりするほうが、AIには伝わりやすい傾向があります。まずは短い言葉で「方向性」を固定し、気に入った絵が出たら言葉を足していくのが正解です。

画像選びで9割決まる。「失敗しない素材」の見分け方

「手持ちのイラストや写真を動かしたい」という時に使う、一番人気のモードです。 ただ、どんな画像でもきれいに動くわけではありません。AIが「理解しやすい画像」を選ぶのが成功の秘訣です。

- 構図: キャラクターが画面の端で見切れていたり、手足が複雑に重なっていたりする画像は避けましょう。AIが「体の構造」を誤解して、腕が3本になったりしやすくなります。「バストアップ(胸から上)」や「全身がすっきり写っている」画像がベストです。

- 光と背景: 背景がごちゃごちゃしていると、動いた瞬間に背景と人物が混ざってしまうことがあります。なるべく背景がシンプルで、光の当たり方がはっきりしている画像を選ぶと、驚くほどきれいに動きます。

カメラワークを盗め!「プロの動画」を自分のものにする方法

「自分の撮った動画」をアップロードして、それを別の映像に変換するモードです。 これは「絵柄を変える」というよりも、「動きとカメラワークを借りる」と考えると分かりやすいでしょう。

例えば、プロのダンサーが踊っている動画を素材にすれば、その「ダンスのキレ」や「カメラのアングル」をそのまま維持して、見た目だけをアニメキャラに変えることができます。 コツは、元になる動画の「輪郭」がはっきりしていること。暗い場所で撮ったボヤけた動画だとAIが動きを読み取れないので、明るい場所で撮影された、動きの分かりやすい動画を用意しましょう。

音ズレを許すな。「気持ちいい動画」を作る音素材の選び方

Seedance 2.0の目玉機能である音声同期。 もしキャラクターにセリフを喋らせたいなら、音声ファイルは「雑音のないクリアな声」を用意してください。BGMが後ろでガンガン鳴っている音声だと、AIが「どこが声なのか」を聞き取れず、口パク(リップシンク)がズレてしまいます。

また、BGMに合わせて映像を作りたい場合は、テンポが一定の曲がおすすめです。変拍子やリズムが激しく変わる曲よりも、4つ打ちのような分かりやすいリズムのほうが、AIが「音ハメ」をしやすくなり、見ていて気持ちのいい動画になります。

顔が変わる問題を解決!「マルチショット」でドラマを作るコツ

「Aのシーン」と「Bのシーン」で、同じキャラクターが登場するのに顔が変わってしまったら興醒めですよね。 これを防ぐためには、「リファレンス(参照画像)」を固定し続けるのが鉄則です。

1カット目を作る時に使った「キャラクターの設定画」を、2カット目、3カット目を作る時にも必ず「参照枠」に入れ続けます。こうすることで、AIに「この人が主役だから顔を変えないでね」と常にリマインドし続けることができます。 さらに、服装や髪型などの特徴的なパーツは、プロンプトでも毎回記述しておくと、より安定感が増します。

プロンプト設計のコツ(初心者→中級へ)

操作に慣れてきたら、次はAIへの指示出し、つまり「プロンプト」を磨いていきましょう。適当な言葉を入れるのと、コツを押さえた言葉を入れるのでは、出来上がりに天と地ほどの差が出ます。

まずは「主語・動作・カメラ・雰囲気」の4点セット

プロンプトを書くとき、何から書けばいいか迷ったら、この4つの要素を順番に並べてみてください。これだけで「伝わるプロンプト」になります。

- 主語(Subject): 誰が?(例:サイバーパンクな女性、巨大なロボット)

- 動作(Action): 何をしている?(例:歩いている、戦っている、コーヒーを飲んでいる)

- カメラ(Camera): どう撮る?(例:クローズアップ、ドローン撮影、下からのアングル)

- 雰囲気(Atmosphere): どんな画作り?(例:映画のような照明、霧がかった、鮮やかな色彩)

「女性が歩く」だけでなく、「(主語)女性が、(動作)ゆっくり歩く、(カメラ)足元のアップで、(雰囲気)夕暮れの切ない光の中で」と書くだけで、一気に映画のようなワンシーンになります。

破綻を減らすキーワード(例:固定カメラ/ゆっくりパン/被写界深度)

AI動画でよくある失敗が、カメラが激しく動きすぎて画面がグニャグニャになる現象です。 これを防ぐ魔法の言葉があります。

- 「Static Camera(固定カメラ)」や「Tripod Shot(三脚撮影)」: 背景を動かさず、キャラクターだけを動かしたい時に有効です。安定感が段違いになります。

- 「Slow Pan(ゆっくりと横移動)」: じわーっと動くリッチな映像にしたい時に使います。

- 「Depth of Field(被写界深度・ボケ味)」: 背景をぼかすことで、多少背景が崩れても目立たなくなり、主役が引き立ちます。

NGを先に書く(入れてほしくない要素を抑える)

「入れてほしいもの」だけでなく、「入れてほしくないもの」を指定することもできます。これを「ネガティブプロンプト」と呼びます。

例えば、「Blurry(ぼやけ)」「Distorted(歪み)」「Extra fingers(余計な指)」「Text(文字)」などをネガティブプロンプトに入れておくと、AIがそれらを避けて生成してくれます。 Seedance 2.0の設定画面に「Negative Prompt」という欄があれば、ここにお守りとしてこれらの単語を入れておくのがおすすめです。

シーンを分割する(1本で詰めない:短尺を積み上げる)

初心者がやりがちなのが、「朝起きて、歯を磨いて、学校に行く少年」というような、時間の経過が必要な指示を1つのプロンプトに詰め込んでしまうこと。 5秒や10秒の動画でこれを全部やろうとすると、AIは早回しのような不自然な映像を作ってしまいます。

プロンプトは「1つの動作」に絞るのが鉄則です。「朝起きる」で1本、「歯を磨く」で1本、「家を出る」で1本。こうして作った短い動画をあとで繋げるほうが、結果的にクオリティの高いストーリーになります。

同じ結果を再現するための「プロンプトのテンプレ化」

うまくいったプロンプトは、自分だけの「レシピ」として保存しておきましょう。 特に「カメラワーク」と「雰囲気」の記述は、他の動画を作る時にも使い回せます。

例えば、「Cinematic lighting, 4k, highly detailed, slow motion(映画のような照明、4K、高精細、スローモーション)」という「雰囲気セット」を作っておけば、主語を「猫」に変えたり「車」に変えたりするだけで、同じトーンのハイクオリティな動画を量産できるようになります。 自分だけのお気に入りフレーズを見つけること、それが上級者への第一歩です。

参照(Reference)活用テクニック:Seedance 2.0の強みを使い切る

Seedance 2.0が「革命的」と言われる理由は、言葉(プロンプト)よりも、見本(参照ファイル)の指示を優先してくれる点にあります。AIに「口で言うより、これを見て!」と資料を渡すテクニックを覚えましょう。

参照の役割を分ける(見た目/動き/編集テンポ/音)

「参照」と一口に言っても、AIに何を真似させたいのかを明確にしないと混乱してしまいます。映画の撮影スタッフに例えると分かりやすいでしょう。

- 画像参照(Image Ref): 「俳優(キャスト)」と「美術セット」を指定する役割。

- 動画参照(Video Ref): 「カメラマン」と「スタントマン」の動きを指定する役割。

- 音声参照(Audio Ref): 「編集者」にリズムやタイミングを指定する役割。

これらを混ぜて指示できるのがSeedance 2.0の凄さです。「顔はこの画像(俳優)、動きはこの動画(スタント)、リズムはこの曲(編集)」と役割分担させて渡すことで、非常に高度な演出が可能になります。

画像参照:キャラ・商品・ロゴの一貫性を上げる

「生成するたびに顔が変わる」というAI動画の最大の悩みを解決するのがこれです。 特に、マンガ動画や企業の広告を作る場合、「キャラクター設定画」や「商品写真」を必ず参照に入れましょう。

コツは、同じキャラクターでも**「正面」「横顔」「バストアップ」など、数パターンの画像をセットで読み込ませる**こと。AIがそのキャラを立体的に理解しやすくなり、横を向いても後ろを向いても「あのキャラ」であり続けてくれます。

動画参照:カメラワークを固定する(“この感じ”を移植)

「プロっぽいカメラワーク」を言葉で説明するのは難しいですが、動画参照なら一発です。 これを「構造転送(Structure Transfer)」と呼ぶこともあります。

例えば、スマホで「自分の部屋をゆっくり一周見渡す動画」を撮ります。これを参照にして、「プロンプト:火星の基地、SF映画風」と指示します。 すると、カメラの動きやアングルは「自分の部屋の動画」と全く同じなのに、映っている景色だけが「火星」になった動画が生成されます。高度なカメラ機材がなくても、手持ちのスマホ動画を「動きの型紙」として使えるのです。

音声参照:テンポ・区切りで映像の編集が決まる

Seedance 2.0は音を聞いています。アップロードしたBGMのビート(拍子)や、ナレーションの切れ目を検知して、映像の動きを合わせてくれる機能があります。

アップテンポな曲を参照に入れると、映像のカット割りや動きもキビキビとしたものになりやすく、逆にゆったりしたピアノ曲を入れると、スローモーションのような落ち着いた映像が生成されやすくなります。「映像のテンポ」を支配したいときは、先に音を決めて参照に入れるのが正解です。

参照を増やしすぎない判断基準(情報過多で崩れるケース)

「最大12個まで参照できる」といっても、入れれば入れるほど良いわけではありません。 例えば、全く違う画風の画像を10枚入れたり、動きの激しい動画を複数入れたりすると、AIはどれを信じていいか分からず、混ざり合って崩れた映像(キメラ)を出してしまいます。

「メインのキャラ画像1〜2枚」+「動きの動画1つ」くらいが一番安定します。「要素を足す」のではなく、「AIの迷いを消す」ために参照を使うのがコツです。

マルチショット(複数カット)で“作品感”を出す構成術

1本の動画(ワンショット)だけでは、TikTokでも数秒でスワイプされて終わりです。 短いカットを繋げて「ストーリー」に見せるマルチショット構成で、視聴者を引き込みましょう。

3ショット基本(導入→見せ場→締め)で短尺ドラマ化

映像制作の基本ですが、以下の3つの構成を意識するだけで、たった15秒でもドラマになります。

- ロングショット(導入): 「どこにいるか」を見せる。遠くから風景全体を映す。

- プロンプト例:遠景、サイバーパンク都市の全景、夜

- ミディアムショット(見せ場): 「誰が何をしているか」を見せる。キャラの腰から上。

- プロンプト例:主人公の女性、何かを見つけて驚く、ネオンの光

- クローズアップ(締め): 「感情」を見せる。顔のアップや、手のアップ。

- プロンプト例:瞳のアップ、涙が光る、詳細な描写

この3つをSeedance 2.0で別々に生成し、あとで繋げるだけで、立派な短編映画の予告編のようになります。

同一人物/同一商品を保つための「固定情報」設計

複数カットを作る時、一番やってはいけないのが「生成された動画のスクショを、次のカットの参照に使うこと」です。これを繰り返すと、伝言ゲームのように画質が劣化し、顔がどんどん歪んでいきます(ジェネレーションロス)。

一貫性を保つ鉄則は、「オリジナルの参照画像(マスター画像)」を使い続けること。 カット1でも、カット2でも、常に最初に用意した「一番きれいなキャラ画像」を参照枠に入れ続けてください。これがブレない動画を作る唯一のルールです。

カットごとに変えるのは1要素だけ(構図 or 表情 or 動作)

カットが変わった瞬間、視聴者が混乱しないようにするためのテクニックです。 「場所も、時間も、服装も、カメラアングルも全部変える」と、前のカットと繋がりがまったく見えなくなります。

- 場所はそのまま、カメラだけ寄る。

- カメラ位置はそのまま、表情だけ変える。

このように、前のカットとの「共通点」を残しつつ「1つだけ変化させる」と、脳が自然に「続きだ」と認識してくれます。

BGM/SFXの入れ方で“つながって見える”ようにする

実は、映像が多少繋がっていなくても、音が繋がっていれば人間の脳は「一連のシーンだ」と補正してくれます。

Seedance 2.0で個別に生成した動画を繋げるとき、BGMだけはブツ切りにせず、1曲を通して流し続ける(または、あとから編集ソフトで通しのBGMを敷く)のがコツです。映像の継ぎ目を音で糊付け(のりづけ)するイメージです。

ループ動画にする(SNS向け:最後を冒頭につなげる)

SNSで再生数を稼ぐなら、終わったことに気づかせずに最初に戻る「ループ動画」が最強です。

やり方は簡単。「最後のカットの終わりのポーズ」と「最初のカットの始まりのポーズ」を似せるのです。 例えば、「カメラに向かって手を振る」で始めて、「手を振りながらフェードアウトする」で終われば、永遠に手を振り続けているようなループ動画が作れます。Seedance 2.0の「動き参照」を使えば、この「最初と最後を合わせる」調整もコントロールしやすくなります。

よくある失敗と直し方(トラブルシューティング)

AI動画生成は「一発成功」なんてまずあり得ません。プロでも何回もやり直しています。 大切なのは、失敗した時に「運が悪かった」で終わらせず、「なぜ失敗したか」を分析して設定を変えることです。

顔が崩れる/別人になる:原因と対処

一番多い悩みがこれです。動画の途中でキャラクターの顔が溶けたり、急に知らないおじさんになったりする現象です。

- 原因: AIが「横顔」や「激しい動き」の最中に、顔の構造を見失ってしまうためです。

- 対処法1(参照画像): 「正面」「斜め」「横顔」など、複数の角度の顔写真を参照枠(Reference)に入れます。AIに「この人は横から見るとこうなるんだよ」と教えてあげるイメージです。

- 対処法2(固定語): プロンプトに「Blue eyes, short hair, mole under right eye(青い目、ショートヘア、右目の下のほくろ)」のように、身体的な特徴を毎回しつこく書きます。これでAIが記憶を取り戻しやすくなります。

- 対処法3(画角): 動きが激しいシーンでは、あえて「引きの画(ロングショット)」にします。顔が小さくなれば、多少崩れても視聴者にはバレません。

手・指・小物が破綻:映さない設計/アップの回避/動きの減量

AIは「手」を描くのが本当に苦手です。指が6本になったり、持っているコーヒーカップが手に融合したりするのは、Seedance 2.0でも完全には避けられません。

- 鉄則: 「怪しいものは映さない」のがプロの技です。

- ポケットに手を入れる、後ろで組む、あるいはバストアップ(胸から上)の構図にして手をフレームアウトさせるのが一番確実な解決策です。

- どうしても手を見せたい場合は、「動きを極限まで減らす(Low Motion)」設定にしましょう。動けば動くほど、指は増殖しようとします。

動きが不自然:カメラ動作を弱める/参照動画で矯正する

人物が地面を滑るように移動したり(ムーンウォーク現象)、背景ごとグニャリと動いたりする場合、原因は「カメラワークの指示しすぎ」か「AIの想像任せ」のどちらかです。

- 直し方1: プロンプトに「Static Camera(固定カメラ)」と入れてみてください。カメラを三脚に据えたように固定すると、人物の動きだけが安定しやすくなります。

- 直し方2: 自分でスマホで撮影した「歩く動画」などを「参照動画(Video Reference)」として読み込ませます。現実の物理法則に従った動きをAIにコピーさせることで、不自然な挙動を強制的に直せます。

画がチラつく:背景を単純化/照明条件を固定

動画の背景がチカチカ点滅したり、家具の配置がコマごとに変わったりする現象です。これはAIが「背景の細部」まで描き込もうとして、処理しきれていない時に起こります。

- 対処法: 背景をシンプルにします。「White background(白背景)」や「Simple studio(シンプルなスタジオ)」と指定するか、「Depth of field(被写界深度)」で背景をボカしてしまいましょう。ボケていれば、多少変化しても気になりません。

- また、プロンプトに「Cinematic lighting(映画的照明)」などの照明指定を入れて、光の当たり方を固定するのも有効です。

音ズレ:無音区間・ビート位置・セリフ尺の調整

口パク(リップシンク)が合わない、ドアが閉まる音のタイミングがズレる、といった音の問題です。

- 確認ポイント: 元の音声ファイルに「無駄な無音(空白)」が入っていませんか? AIは音声波形の頭から口を動かし始めることが多いので、音声ファイルの冒頭にある無音部分はカットしてからアップロードしましょう。

- ビート位置: ダンス動画などで音に合わせたい場合、AI任せにするよりも、生成した動画を編集ソフト(CapCutなど)で0.1秒単位でズラすほうが早くて確実です。「素材作りはAI、タイミング合わせは人間」と割り切るのがコツです。

用途別レシピ(すぐ真似できる具体例)

ここからは、「これを作りたいなら、この設定!」という鉄板の組み合わせ(レシピ)を紹介します。自分の作りたいものに合わせて真似してみてください。

SNSショート:テンポ重視の3〜5カット構成

TikTokやReels、YouTube Shortsでバズりやすい、テンポの良い動画の作り方です。

- 構成: 1カット2〜3秒 × 3〜5枚。計10〜15秒。

- レシピ:

- インパクト(3秒): 派手な動きや、変な顔のアップ。「Camera Zoom In(ズームイン)」で勢いをつける。

- 展開(3秒): 何をしているか分かる全身ショット。

- オチ(3秒): 意外な結末や、最初に戻るためのポーズ。

- コツ: BGMを先に決め、そのリズムに合わせてカットを割ること。最後に「冒頭のポーズ」に近い動きを持ってくれば、無限ループ動画の完成です。

広告/EC:商品一貫性+“使用シーン”2パターン量産

商品を売りたい、ブランド動画を作りたい場合のレシピです。商品のロゴや形状が変わらないことが絶対条件です。

- 必須設定: 商品写真を「Image Reference(画像参照)」に入れ、影響度(Strength)を強めに設定。

- パターンA(ブツ撮り): 商品そのものを魅力的に見せる。「Cinematic lighting, slow pan」で、高級感のある光の中、ゆっくり回転させる。

- パターンB(使用シーン): 人が使っている様子。「Smiling woman holding [product]」で、モデルに持たせる。

- 注意点: 指が崩れやすいので、持つ手はなるべく映さないか、動きを止めるのが無難です。

マンガ動画:キャラ固定・口パク・字幕の鉄板セット

YouTubeでよく見る「動くマンガ」や「解説動画」です。

- レシピ:

- キャラクターの立ち絵(バストアップ)を用意。

- 「Lip Sync(リップシンク)」モードを選択。

- 喋らせたい音声をアップロード。

- プロンプトは「Slight movement, breathing(わずかな動き、呼吸)」程度に留める。

- コツ: 派手に動かすと顔が変わるので、「口とまばたき以外は動かさない」のが正解です。これに字幕と背景を合成すれば、低コストでアニメのような動画が量産できます。

短尺ドラマ:登場人物2名・固定舞台で破綻を最小化

ストーリー性のあるドラマを作りたい場合、要素を増やしすぎないのが成功の鍵です。

- レシピ: 「ワンシチュエーション(1つの場所)」ドラマ。

- 登場人物: 最大2人まで。

- 撮影法: 会話シーンは「切り返し(Shot Reverse Shot)」を使います。

- カット1:Aさんが喋る(Bさんは背中か映さない)。

- カット2:Bさんが喋る(Aさんは背中か映さない)。

- コツ: ツーショット(2人が同時に映る画)はAIが混乱して顔が混ざりやすいので、なるべく1人ずつ映すのがクオリティを保つ秘訣です。

プリビズ:絵コンテ→参照動画でカメラ案を作る

これは映像制作者向けのプロ技です。本番の撮影前に「どんなカメラワークにするか」をシミュレーション(プリビズ)する使い方です。

- レシピ:

- 手書きの絵コンテや、簡単な棒人間のイラストを描く。

- それを「Image Reference」に入れる。

- プロンプトで「Realistic camera movement, movie scene」と指示。

- メリット: 棒人間の絵が、一瞬で「リアルな配置の映像」に変換されます。これでカメラアングルや照明のプランを練ってから本番の撮影に挑めば、現場での失敗がなくなります

安全・権利・炎上を避けるための最低限のルール

Seedance 2.0は性能が高すぎるゆえに、悪用されると危険なツールでもあります。「知らなかった」では済まされないルールを確認しましょう。

実在人物・有名人の扱い(参照制限の背景と注意点)

「憧れの俳優さんを自分の映画に出したい!」と思っても、それは絶対にNGです。

Seedance 2.0では、実在する有名人の画像を参照(Reference)に入れて動画を作ろうとすると、エラーが出たり、アカウントが停止されたりすることがあります。これは「ディープフェイク(偽動画)」による世論操作や名誉毀損を防ぐための措置です。

有名人に限らず、「許可を取っていない他人の顔」を使って動画を作るのも肖像権の侵害になります。参照画像には、自分が描いたイラストや、生成AIで作った架空の人物、あるいは撮影許可を得たモデルさんの写真だけを使うようにしましょう。

音声クローン・声真似のリスク(本人同意・利用範囲)

映像だけでなく、音声も同じです。Seedance 2.0の音声生成機能を使えば、特定の人に似た声を作れてしまいますが、これもトラブルの火種になります。

「好きな歌手の声で歌わせる」「有名人の声で変なことを言わせる」といった行為は、パブリシティ権の侵害や名誉毀損で訴えられるリスクが高いです。

特に音声は「騙されやすい」ため、プラットフォーム側も監視を強めています。「自分の声」や「商用利用可能なフリー素材の声」を使うのが、一番安全で確実な方法です。

著作権(素材音源・ロゴ・既存映像の参照)の考え方

「参照動画(Reference Video)」として、映画のワンシーンや、テレビのアニメを読み込ませるのはどうでしょうか?

個人的に試すだけならグレーゾーンな場合もありますが、それをSNSで公開したり、YouTubeで収益化したりするとアウト(著作権侵害)になる可能性が高いです。

- 映像: 映画、アニメ、他人のYouTube動画は参照に使わない。

- 音楽: 市販のCD音源や、好きなアーティストの曲を参照に使わない。

- ロゴ: 生成された動画に、うっかり有名ブランドのロゴが映り込んでいないかチェックする。

「素材は自分で用意する(自撮りやフリー素材)」が、AI動画制作の基本マナーです。

商用利用前チェックリスト(規約・表示・権利確認)

作った動画を仕事で使いたい、YouTubeで広告収入を得たいという人は、以下の3つを必ずチェックしてください。

- プラン確認: 無料版(Free Tier)で作った動画は商用利用NGなことが多いです。有料版(Pro/Standard)が必要か確認しましたか?

- AI表示義務: YouTubeやTikTok、Instagramでは、「AIで作った動画」にはラベル(タグ)を付けることが義務付けられ始めています。隠して投稿すると、アカウント制限の対象になることがあります。

- 権利クリア: 参照に使った画像や音楽は、本当に商用利用OKなものですか?

他の動画AIとの比較(気になる人向け)

「結局、SoraやVeoとどっちがいいの?」と迷っている人のために、Seedance 2.0の立ち位置を整理します。

Sora / Veo / Klingなどと比べた強み・弱み

| AIモデル | 強み(得意なこと) | 弱み(苦手なこと) |

| Seedance 2.0 | 音まで作れる、参照で演出を細かく指示できる、キャラ固定が得意 | 1回の生成秒数が短め、リアルな物理法則はたまに無視する |

| Sora (OpenAI) | 映像のリアリティが圧倒的、物理法則に忠実 | 音は作れない、細かい演出指示(カメラワーク等)が難しい |

| Veo (Google) | 解像度が高い、YouTubeなどGoogle系サービスとの連携 | 使える場所が限定的、キャラクターの固定が少し苦手 |

| Kling | アジア系の顔立ち生成が得意、動きが滑らか | 音は作れない、欧米風のリアルな描写はSoraに譲る |

「映像品質」より「制作フロー短縮」に向くケース

もしあなたが「ハリウッド映画並みの、超リアルな風景映像」を1カットだけ作りたいなら、Soraの方が向いているかもしれません。

ですが、Seedance 2.0が真価を発揮するのは「動画作品を完成させたいとき」です。

- BGMを探す手間がいらない。

- 効果音(SE)を付ける手間がいらない。

- キャラの顔を統一する手間が少ない。

「クオリティ90点の素材を、爆速で完成品にする」能力において、Seedance 2.0は他のAIの追随を許しません。SNS運用や広告制作など、スピードと量が求められる現場では最強のツールと言えます。

どれを選ぶ?用途別おすすめ(SNS/広告/作品制作)

- SNS(TikTok/Reels): 間違いなくSeedance 2.0。音付きでキャッチーな動画がすぐ作れるからです。

- 広告・PR動画: Seedance 2.0。商品やロゴの一貫性を保ちやすいからです。

- 映画・MVの素材: Sora や Veo。圧倒的な画質が必要な「キメのカット」はこれらで作り、つなぎのカットや音付けにSeedanceを使う「ハイブリッド」も賢い方法です。

今後どうなる?Seedance 2.0の伸びしろと注目ポイント

解像度・尺が伸びる可能性(提供形態で差が出る理由)

現在は「最大15秒」「1080p」といった制限がありますが、これは技術的な限界というより「サービスの都合」です。

AIモデル自体はもっと長く、高画質な動画を作る能力を持っています。今後、スマホの性能が上がったり、有料の「Pro Maxプラン」のようなものが出たりすれば、4K画質で1分間の動画を一発生成できる日もそう遠くはないでしょう。

編集統合(CapCut連携)で“ワンストップ化”が進むか

ByteDance社は動画編集アプリ「CapCut」を持っています。

今後、CapCutの中にSeedance 2.0が完全に組み込まれると予想されます。「動画を編集していて、足りないカットがあったらその場でAIに作らせる」「BGMが合わないからAIに作り直させる」といったことが、スマホ1つで完結するようになるはずです。これが実現すれば、動画制作の敷居は一気に下がります。

規制・ウォーターマーク・本人保護の動き

一方で、フェイク動画への風当たりは強くなっています。

今後は、動画の中に目に見えない「デジタル透かし(電子透かし)」が埋め込まれ、「これはAI製です」と自動で判別される仕組みが標準になるでしょう。また、有名人の顔や声を保護するための法整備も進むはずです。技術の進化とルール作りは、これからもしばらく追いかけっこが続きます。

まとめ:Seedance 2.0を最短で使いこなす3原則

長くなりましたが、Seedance 2.0を使いこなすために覚えるべきことは、たった3つです。

この3原則さえ守れば、あなたは今日から「AI動画クリエイター」として活躍できます。

原則1:参照で演出意図を固定して“ガチャ”を減らす

言葉(プロンプト)だけで頑張らないでください。「この画像のような顔で」「この動画のような動きで」と、見本(参照)を渡してAIにカンニングさせること。これが失敗を減らす一番の近道です。

原則2:短尺で試して、良いカットを積み上げる

いきなり長編映画を作ろうとしないでください。「4〜5秒の奇跡的なカット」をいくつか作り、それを繋げていくこと。プロの作品も、実は短いカットの集合体です。

原則3:音と編集テンポを設計して“作品感”を作る

映像だけでなく、音もAIに任せられるのがSeedance 2.0の強みです。「音が合っている」だけで、動画のクオリティは数倍良く見えます。生成された音を活かしつつ、最後は自分の手でタイミングを微調整して、「作品」へと仕上げてください。

さあ、スマホの中にある画像や、何気なく撮った動画をSeedance 2.0に入れてみてください。

あなたの想像もしなかった「新しい物語」が、音と共に動き出すはずです。

コメント