動画生成AIと聞くと、「文章を書いたら動画が出てくる魔法」を想像する人が多いと思います。実際、それはもう当たり前になりつつあります。

でも、動画を作る側(投稿・広告・作品づくり)にとって本当に大事なのは、1本が出せることよりも、次の2つです。

1つ目は、同じ企画で“複数のカット”を作り、比べて、直して、完成に近づけること。

2つ目は、キャラの動きが狙い通りに出ることです。

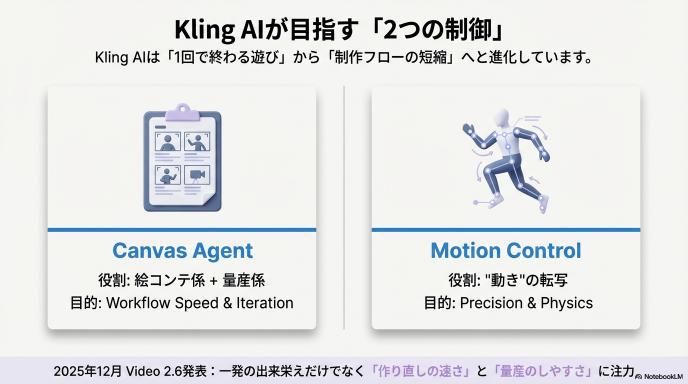

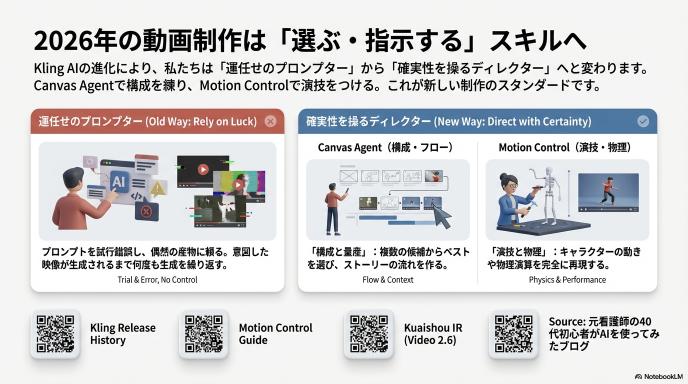

Kling AIは、この2つを取りにいくために、機能を大きく2方向に伸ばしています。

それが Canvas Agent(エージェント機能)と、Motion Control(モーションコントロール)です。公式のリリース情報でも、この2つは制作体験を変える柱として扱われています。

音声のみはこちら↓

Kling AIって結局なにが“特徴”なの?

一言でいえば、Kling AIは「1回の生成で終わる遊び」ではなく、制作の流れ(ワークフロー)そのものを速くする方向に進んでいます。

たとえば、Kling AIの公式チュートリアル(Quickstart)やリリース履歴には、生成だけでなく「どう使えば制作が速くなるか」という“運用”の視点が前面に出ています。

さらに、2025年12月の対外発表では、Video 2.6 のアップデートとして「同時の音声・映像生成」など、制作の工程をまとめて短縮する方向性も語られています(企業側の公式発表)。

つまり、Kling AIが目指しているのは「一発の出来栄え」だけではなく、“作り直しの速さ”や“量産のしやすさ”に強い制作環境です。

まずはエージェント:Canvas Agentは「絵コンテ係」+「量産係」

「エージェント機能」って何をしてくれるの?

難しく聞こえますが、高校生向けに超ざっくり言うと、Canvas Agentは、

- 企画(こういう動画を作りたい)

- カット割り(どんな場面を何個作るか)

- 複数案づくり(候補を並べる)

- 修正(会話で詰める)

を、1つの場所で回すための仕組みです。

公式のリリース履歴では、Canvas Agentのポイントとして、Smart Multi-Shot(複数ショット化)、Multi-angle Expansion(アングル違いの展開)、Multi-round dialogue editing(会話で編集)、そしてOne-click batch generation(まとめて生成)がまとめて紹介されています。

どう嬉しいの?(日常の例で)

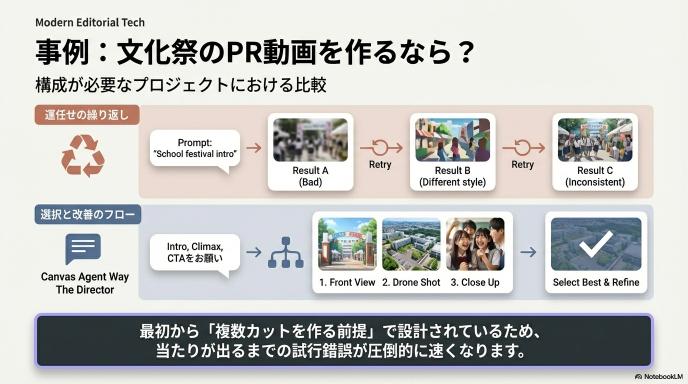

たとえば「文化祭のPR動画」を作るとします。

“1本だけ”なら、テキストで動画を出して終わりでもOKです。でも実際は、

- 入口の場面

- 盛り上がる場面

- 参加を呼びかける場面

みたいに、複数の場面が必要になります。さらに、入口の場面だけでも「正面」「斜め」「引き」みたいに候補が欲しくなります。

ここでCanvas Agentが強いのは、最初から“複数カットを作る前提”で設計されていることです。

“会話で編集”は地味に効く

生成AIは、細かい指示を全部一発で当てるのが難しいです。だから現実的には、

出す → 見る → 直す → もう一回出す

の繰り返しになります。

Canvas Agentは、この繰り返しを「会話」で回せることが明記されています。

文章で指示→結果→追加指示、という形に寄せることで、編集の入口が軽くなる。これが“制作が速くなる”の正体です。

次はモーション:Motion Controlは「動き」を参照して“ズレ”を減らす

そもそも「動き」はなぜ難しい?

普通の動画生成AIだと、動きを作るときに「走る」「踊る」「振り向く」みたいな言葉で指示します。

でも言葉だけだと、AIはわりと自由に解釈します。結果として、

- 走り方が変

- 腕の動きがぎこちない

- カメラが変に揺れる

- 同じ指示でも毎回違う

みたいなことが起きます。

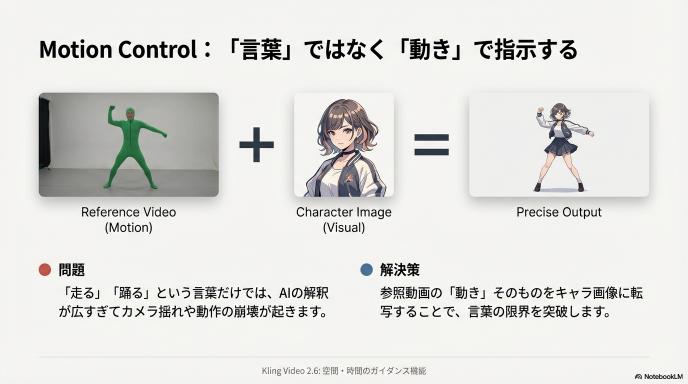

Motion Controlは“動きを見せて”指示する

Motion Controlは、公開情報上、「参照動画の動き(モーション)を、キャラクター画像に転写して動画を生成する」機能として説明されています。

つまり、言葉で説明しにくい動きは、実際の動きの動画を渡してしまう。そうすると、狙った方向に寄せやすくなります。

第三者の整理でも、Kling 2.6 Motion Controlは「空間・時間のガイダンス」によって、カメラ軌道やキャラクターの動きをより予測可能にする、という説明がされています(外部解説だが具体的に機能の狙いを言語化している)。

たとえば何に使える?

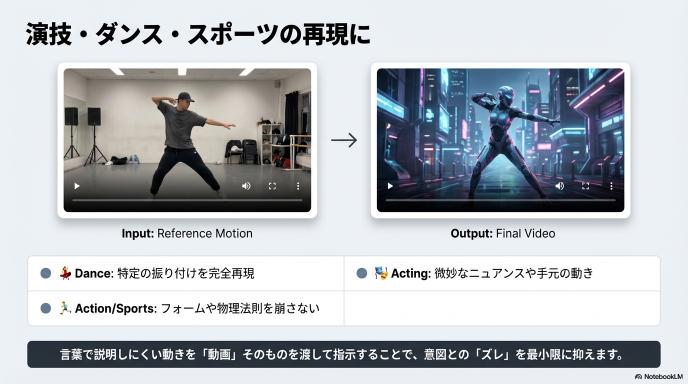

分かりやすいのは「ダンス」や「スポーツ」です。

PR発表でも、ダンス動画などを参照にして、狙った動きを別キャラで表現できる、という方向で説明されています。

ただし大事なのは、Motion Controlは“万能の魔法”ではなく、参照動画の質に結果が引っ張られることです。

公式のMotion Controlページでは、画像(キャラ)と動画(モーション)どちらの向き・一致が重要か、といった注意が書かれており、入力の整え方が品質に直結するタイプの機能だと読み取れます。

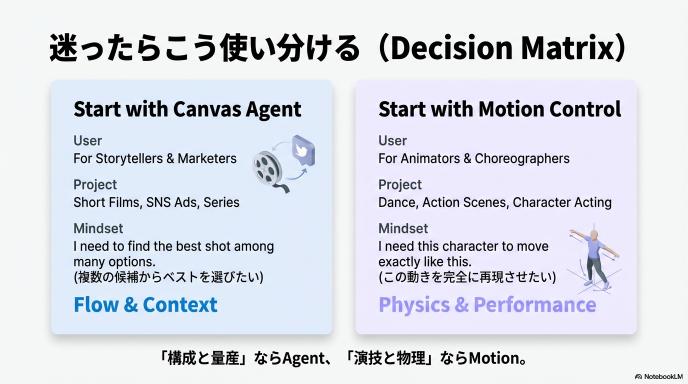

じゃあ結局、どっちを先に使えばいい?

ここは迷いやすいので、短い文章で整理します。

Canvas Agentが先に刺さる人

あなたが作りたいのが「ショート動画」「SNS投稿」「広告」「シリーズ物」みたいに、

同じ企画を何本も作って当たりを探すタイプなら、先にCanvas Agentの価値が出やすいです。

理由は単純で、当たりを出すには候補が必要で、候補を出すには“まとめて作る仕組み”が必要だからです。

Motion Controlが先に刺さる人

あなたが作りたいのが「踊り」「演技」「手元の動き」「決まったアクション」みたいに、

動きそのものが主役なら、Motion Controlが先に効きます。

言葉で指定するより、動きを参照で渡すほうが、ズレが減りやすいからです。

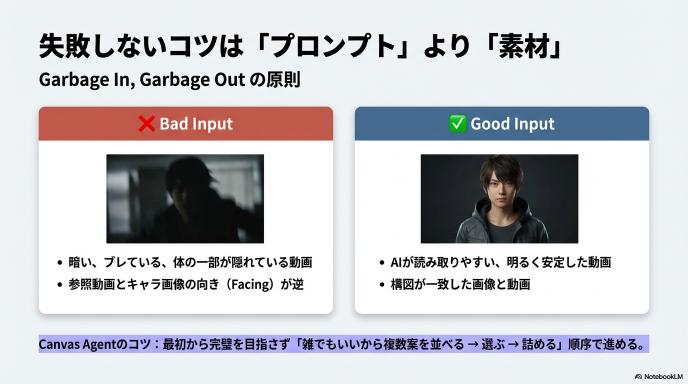

失敗しないコツ:「うまいプロンプト」より「うまい素材」

最後に、無駄な精神論ではなく、実務的に効く話をします。

Kling AI(特にMotion Control)は、入力が結果を大きく左右します。

- 参照動画が暗い、ブレる、体が隠れる → 動きが崩れやすい

- キャラ画像の向きや構図が参照とズレる → カメラワークや動きの解釈がズレやすい

これは公式ページ上の注意とも整合します。

つまり、上達の近道は「文章力」だけではなく、“AIが読み取りやすい素材”を用意する力です。

そしてCanvas Agent側は逆に、最初から完璧を狙うより、

雑でもいいから複数案を並べる → 良い案を残す → そこから詰める

という順番にしたほうが、機能の設計思想に合っています(Smart Multi-Shot / batch generation がその方向)。

コメント